关键词:PVE | Proxmox VE | RAID | RAID0 | LVM | LVM-thin | 缓存 | cache | HDD | SSD

前言

最近在查阅资料各种资料,看看PVE单服务器系统中,能用什么样的方式,提升LVM-thin存储的IO性能。有多服务器条件的当然是上CEPH了,没有多服务器的条件而内存又比较充足的情况下使用ZFS也不错。但我两种条件都不具备。

作为垃圾佬,怎么舍得再额外购置硬件多花钱呢。垃圾佬当然不愿意再购买新硬盘了,掏出多年前给台式机装系统的两块SATA接口的固态硬盘,以及以前台式机用的两块机械硬盘,准备将两块SSD组raid0后作为缓存池,为两块HDD以raid0组后创建的LVM-thin提供读写缓存服务。

| 硬盘类型 | 型号 | 硬盘大小 | 通电时长 | 出厂时间 |

|---|---|---|---|---|

| SSD | Samsung 840 EVO | 120G | 28744h | 2014年3月 |

| SSD | Samsung 850 EVO | 120G | 22981h | 2015年5月 |

| HDD | WD20EZRX | 2T | 55700h | 2013年2月 |

| HDD | HGST HUA723020ALA640 | 2T | 19267h | 2013年12月 |

和我的使用场景、硬件条件一模一样几乎是不可能的,也就几乎不可能有人能够完全照搬我的操作过程,所以本文也仅是提供一种思路,LVM依靠它已经提供的各种功能,可以实现各种你想得到想不到的玩法。这里举三个例子:

-

2块2T的HDD、1块3T的HDD,3块HDD分别创建一个2T的分区,共3个2TiB的分区组建6T大小3个PV的raid0的LVM或LVM-thin;再将3T盘没有用到的1T空间单独再创建个dir存储,用于保存备份文件、镜像文件等。

-

1块256G的nvme磁盘,安装系统已经占用了50G,余下的空间大又不大,小又不小,单独用好像也干不了什么太多的事。系统已经默认创建了local-lvm,但是可以将local-lvm删除,然后将产生的约200G空间作为其他HDD磁盘的缓存池,提升IO性能。

-

4块4T的HDD组raid5后再转换为LVM,然后一块256G的nvme磁盘作为其缓存池。

有关概念

PV(physical volume):物理卷,在逻辑卷管理系统最底层,可为整个物理硬盘或实际物理硬盘上的分区。

VG(volume group):卷组,建立在物理卷上,一卷组中至少要包括一物理卷,卷组建立后可动态的添加卷到卷组中,一个逻辑卷管理系统工程中可有多个卷组。

LV(logical volume):逻辑卷,建立在卷组基础上,卷组中未分配空间可用于建立新的逻辑卷,逻辑卷建立后可以动态扩展和缩小空间。

PE(physical extent):物理区域,是物理卷中可用于分配的最小存储单元(本文采用默认值4MiB),物理区域大小在建立卷组时指定,一旦确定不能更改,同一卷组所有物理卷的物理区域大小需一致,新的PV加入到VG后,PE的大小自动更改为VG中定义的PE大小。

LE(logical extent):逻辑区域,是逻辑卷中可用于分配的最小存储单元,逻辑区域的大小取决于逻辑卷所在卷组中的物理区域的大小。

网上有很多有关概念的详细介绍,这里不再多说。

创建具有缓存池的LVM-thin存储

这里需要大致先说明一下我的思路,我打算将HDD全部空间组raid0,然后用作数据LV;将SSD全部空间组raid0,然后用作元数据LV和缓存池LV,最终的存储类型是LVM-thin。分别如下:

-

数据LV:也就是存储LVM-thin原始数据的LV,所有数据最终需要写入的地方,我将在HDD上创建它。

-

元数据LV:LVM-thin的特色,相比LVM直接按卷大小预先分配所需空间,LVM-thin则是需要向卷内写入数据时才按实际写入数据量大小分配所需空间。LVM-thin需要用来索引实际数据的元数据metadata空间,就是元数据LV。为了提升数据索引速度,我将在SSD上创建它。

-

缓存池LV:为了提升访问数据LV中数据的IO速度,使用SSD为它创建缓存池,这样可以将经常读取的数据加载到缓存池中,后续再读取这些数据会提升IO;同时要写入数据时也先写入缓存池,写入也可以更快。缓存池LV也分为数据LV和元数据LV两部分。

-

缓存池数据LV:临时存储缓存数据的地方,我将在SSD上创建它。

-

缓存池元数据LV:索引缓存数据的元数据存储的地方,我也将在SSD上创建它。

-

-

还有额外的备用池元数据LV,后文遇到时再作介绍。

如果直接在PVE的WEBUI中来创建,无法实现我所设想的思路,所以只能通过命令行来创建,然后再经过多次转换,来转换为我所需要的LVM-thin。

先看看磁盘的识别情况

|

|

从输出可见,/dev/sdb和/dev/sdc是两块HDD,/dev/sdd和/dev/sde是两块SSD:

|

|

对磁盘初始化

给2块SSD、2块HDD磁盘全部以GPT进行初始化,每个磁盘只分一个区,以下以/dev/sdb为例(不分区直接创建整盘PV也可以):

|

|

全部分好区再输入lsblk检查一下:

|

|

输出:

|

|

创建PV

|

|

输出:

|

|

创建VG

采用默认的4M大小的PE,创建名叫hybrid的VG:

|

|

输出:

|

|

创建数据LV

给两块HDD组raid0,用完它们的全部空间创建名叫data的数据LV:

|

|

输出:

|

|

RAID的Stripe Size大小可以设置为8KiB、16KiB、32KiB、64KiB、128KiB和256KiB,如不设置此参数则默认采用64KiB。

对于数据库应用,Stripe Size在4-16KiB之间被证明效果比较好;对于Web服务器以及文件打印服务器,建议Stripe Size设置为16-64KiB;对于大文件环境,比如流媒体,建议Stripe Size设置为128KiB以上。

我的主要是大文件,所以我设置Stripe Size为256KiB。并且我的使用场景下,主要目的是提升IO,反而对数据损坏这个情况不关心,坏了就坏了,所以我采用的是raid0,和我使用场景不一致的不要采用raid0以及256KiB的Stripe Size。

创建元数据LV和缓存池元数据LV

-

我最终要创建的存储类型是LVM-thin,这种薄存储类型需要另外的空间存储元数据metadata,如果直接在HDD上创建LVM-thin,系统会自动在HDD上创建其对应的元数据LV。但我们现在创建的是raid0类型的LVM,默认不带元数据LV,并且另一方面,我希望能在SSD上创建元数据所需要的LV,这样还可以提升数据索引速度,所以我需要手动在SSD上创建最终的LVM-thin存储所需要的元数据LV。

-

并且,我们后面将SSD作为缓存池cachepool时,缓存池它本身也需要存储元数据,所以这里也需要为缓存池创建缓存池元数据LV。

-

另外,我有两块SSD,我希望能最大化的提升IO,所以这两块SSD之间也需要组raid0。

首先为最终要创建的LVM-thin存储创建名叫meta_thinpool的元数据LV,创建时它默认是数据LV大小的0.1%,我取约0.3%,创建11.5GiB的元数据LV(不能超过15.81GiB)。

存储元数据的raid0组Stripe Size我就保持默认的64KiB吧(不添加–stripesize即使用默认值)。

|

|

输出

|

|

再为后面马上要创建的的缓存池LV创建名叫meta_cachepool的缓存池元数据LV,raid0组也使用默认的Stripe Size,大小就取528M(大约也是缓存池LV的0.3%)吧。

|

|

有关元数据LV大小应该设置多大,可以查看官方建议:lvmthin.7.en#Size_of_pool_metadata_LV

输出

|

|

创建缓存池数据LV

在SSD上已经创建好了两个metadata的LV,占了一点空间,为了最大化利用磁盘空间,先把两块SSD余下的空间全部分配给缓存池数据LV。不过如果后续进行lvconvert转换存储类型操作时,如未设置关闭自动创建备用池元数据LV(即命令中添加--poolmetadataspare n,在PVE的WEBUI中创建LVM-thin,系统也会默认创建备用池元数据LV),在进行转换操作时就需要额外的等同于hybrid/meta_thinpool大小(我这里就是11.5GiB)的空间。我打算让其自动创建备用池元数据LV,所以我需要预留11.5GiB(即2944个PE)。

如果已经在LVM-thin创建了虚拟磁盘,没有任何剩余空间的话,后续再调整就不太好调整了,所以如果不太放心的话,你多保留一些空间不完全创建LV也是可以的。

为了最大化的提升IO性能,缓存池也采用raid0。同样采用默认的Stripe Size。

|

|

转换存储类型

- 转换

hybrid/cache这个LV的类型为缓存池cache-pool,设置chunksize为256KiB,指定缓存池元数据LV为之前已经在SSD上以raid0创建的hybrid/meta_cachepool:

|

|

这一步操作中chunksize的值应该参考下方说明中lvmcache有关的说明进行设置。输出如下,这样,缓存池元数据LVhybrid/meta_cachepool和缓存池数据LVhybrid/cache就合并成新的缓存池LV了。

|

|

有关chunksize的说明

The size of chunks in a snapshot, cache pool or thin pool. For snapshots, the value must be a power of 2 between 4KiB and 512KiB and the default value is 4. For a cache pool the value must be between 32KiB and 1GiB and the default value is 64. For a thin pool the value must be between 64KiB and 1GiB and the default value starts with 64 and scales up to fit the pool metadata size within 128MiB, if the pool metadata size is not specified. The value must be a multiple of 64KiB. See lvmthin(7) and lvmcache(7) for more information. 机翻:快照、缓存池或精简池中的块大小。对于快照,该值必须是2的幂,介于4KB和512KB之间,默认值为4。对于缓存池,该值须介于32KiB和1GiB之间,并且默认值为64。对于精简池,该数值必须介于64KiB和1GiB之间,如果未指定池元数据大小,则默认值从64开始,并按比例放大以适应128MiB内的池元数据大小。该值必须是64KiB的倍数。有关更多信息,请参见lvmthin和lvmcache。

lvmthin:

When a thin pool is used primarily for the thin provisioning feature, a larger value is optimal. To optimize for many snapshots, a smaller value reduces copying time and consumes less space. 机翻:当精简池主要用于精简资源调配功能时,最好使用较大的值。要优化多个快照,较小的值可以减少复制时间并消耗更少的空间。

lvmcache:

Using a chunk size that is too large can result in wasteful use of the cache, in which small reads and writes cause large sections of an LV to be stored in the cache. It can also require increasing migration threshold which defaults to 2048 sectors (1 MiB). Lvm2 ensures migration threshold is at least 8 chunks in size. This may in some cases result in very high bandwidth load of transfering data between the cache LV and its cache origin LV. However, choosing a chunk size that is too small can result in more overhead trying to manage the numerous chunks that become mapped into the cache. Overhead can include both excessive CPU time searching for chunks, and excessive memory tracking chunks. 机翻:使用过大的块大小可能会导致缓存的浪费使用,在这种情况下,较小的读取和写入会导致LV的较大部分存储在缓存中。它还可能需要增加迁移阈值,默认为2048个扇区(1个MiB)。Lvm2确保迁移阈值的大小至少为8个块。在某些情况下,这可能导致在高速缓存LV与其高速缓存源LV之间传输数据的非常高的带宽负载。然而,选择太小的块大小可能会导致管理映射到缓存中的大量块的更多开销。开销可能包括过多的CPU时间搜索块,以及过多的内存跟踪块。

- 把之前在HDD上创建的

hybrid/data这个LV的类型转换为带缓存池LV(hybrid/cache)的存储类型,指定缓存池为刚刚合并后的缓存池LVhybrid/cache,设置缓存模式为writeback:

|

|

输出如下,这样,数据LVhybrid/data就和缓存池LVhybrid/cache合并成新的带缓存池的LVM存储hybrid/data了,这个时候它还不是LVM-thin存储。

|

|

缓存模式可选择如下,我都raid0了,已经无所畏惧了,所以我选择writeback,数据丢了就丢了吧:

writeback: writeback considers a write complete as soon as it is stored in the cache pool.

writethough: writethough considers a write complete only when it has been stored in both the cache pool and on the origin LV. While writethrough may be slower for writes, it is more resilient if something should happen to a device associated with the cache pool LV.

passthrough: With passthrough, all reads are served from the origin LV (all reads miss the cache) and all writes are forwarded to the origin LV; additionally, write hits cause cache block invalidates. See lvmcache(7) for more information.

- 再把刚刚合并的带缓存池的LVM存储

hybrid/data与之前创建的元数据LVhybrid/meta_thinpool合并转换为最终需要的LVM-thin存储:

|

|

有关chunksize的具体说明见上方,这一步操作中chunksize的值应该参考上方说明中lvmthin有关的说明进行设置。如采用默认64KiB的chunksize,最大可支持15.81TiB的LVM-thin。我的输出如下:

|

|

检查

最后,我们来看看LV和物理磁盘的情况

|

|

输出如下:

|

|

从输出中的Layout和Devices字段可以看出,hybrid/data这个综合了raid0、缓存池和具有thin功能的LVM-thin,内部的各个下级LV:

-

它的数据LV

data_tdata大小是3.64TiB,其实就是两块HDD大小之和(2T盘的实际大小是1.82TiB),它的原始(orig)数据LV是data_tdata_corig,而data_tdata_corig是由两块HDD的/dev/sdb1和/dev/sdc1分区组的raid0(data_tdata_corig_rimage_0和data_tdata_corig_rimage_1); -

它所需要的元数据LV(即

data_tmeta)大小是11.5GiB,也是raid0组,这个raid0组位于两块SSD上,即data_tmeta_rimage_0和data_tmeta_rimage_1; -

它有一个缓存池LV

cache_cpool,而缓存池LVcache_cpool本身又分为数据和元数据两部分:

-

缓存池数据LV是

cache_cpool_cdata,总大小200GiB,是位于两块SSD上的cache_cpool_cdata_rimage_0和cache_cpool_cdata_rimage_1组成的raid0; -

缓存池元数据LV是

cache_cpool_cmeta,总大小528MiB,也是由位于两块SSD上的cache_cpool_cmeta_rimage_0和cache_cpool_cmeta_rimage_1组成的raid0。

- 转换存储类型还生成了

lvol0_pmspare,这个是自动创建的备用池元数据LV,备用池元数据LV是在修复池时可以使用的保留空间。它的大小等同于最大的元数据LV大小(我创建的两个元数据LV中较大的是11.5GiB)。如想关闭自动创建这种类型的LV,需要在与元数据LV有关的两次转换命令lvconvert中添加--poolmetadataspare n。如果设置了不自动创建,那么前面的存储类型转换时也就不需要提前预留空间。虽然看起来有两个(因为我进行了两次与元数据有关的转换lvconvert),但实际上是在两块SSD上总共占用11.5GiB,每块SSD各5.75GiB。

每块SSD上的LV有:缓存池数据LV(cache_cpool_cdata)100GiB,缓存池元数据LV(cache_cpool_cmeta)264MiB,元数据LV(data_tmeta)5.75GiB,备用池元数据LV(lvol0_pmspare)5.75GiB。以上总计111.76GiB,这就是120G的SSD的真实大小。

这样,将元数据LV、缓存池数据LV、缓存池元数据LV全部放在SSD上以提升IO性能,两块HDD组成数据LV以保存原始数据,那么HDD大小之和3.64TiB就是这个LVM-thin存储的最终大小。

再以另外一个角度来看:

|

|

从输出也可以看到HDD上只有data,两个metadata和cache全部位于SSD:

|

|

添加存储

把创建好的LVM-thin存储添加到PVE,就大功告成了:

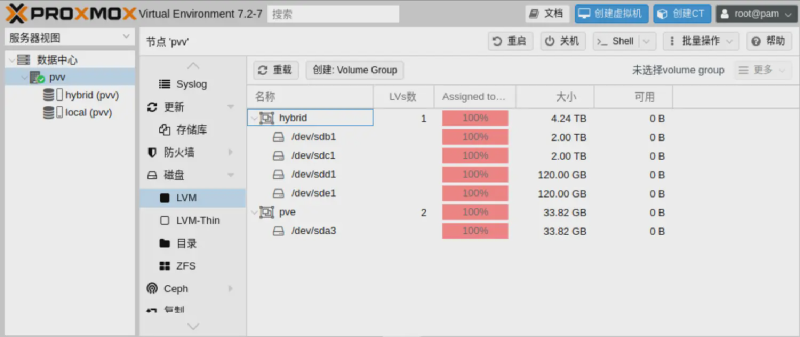

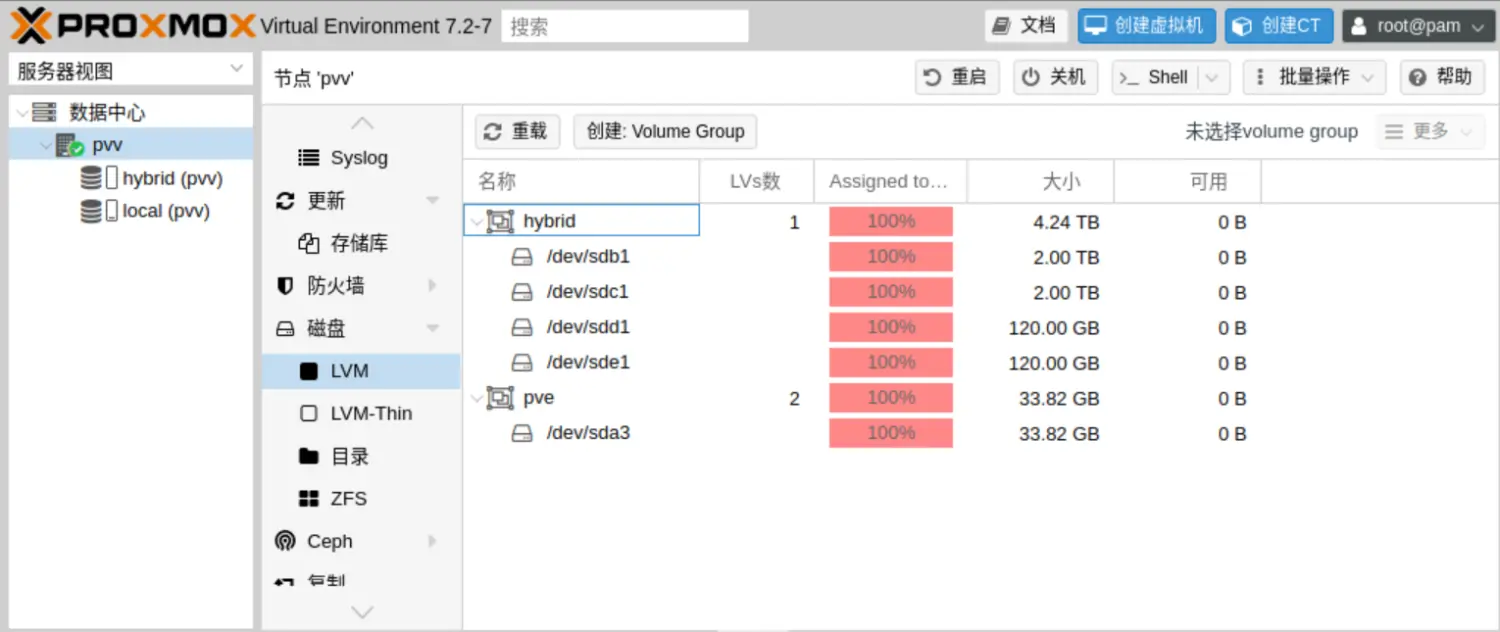

顺便再看看磁盘空间有没有100%利用完全:

参考资料

lvm, pvcreate, vgcreate, lvcreate, lvconvert, lvreduce, lvremove, lvs, lvmraid, lvmthin, lvmcache

在上述参考资料链接下方可以看见全部命令的帮助文档,同时也可以直接在PVE命令行中输入man <cmd>来查阅上述文档。